父の日。

娘はロンドンに行っている。

息子は父の日を祝ってもらっている。

父の日はドライだ。

それがいい。

さて今、一番大事な問題。

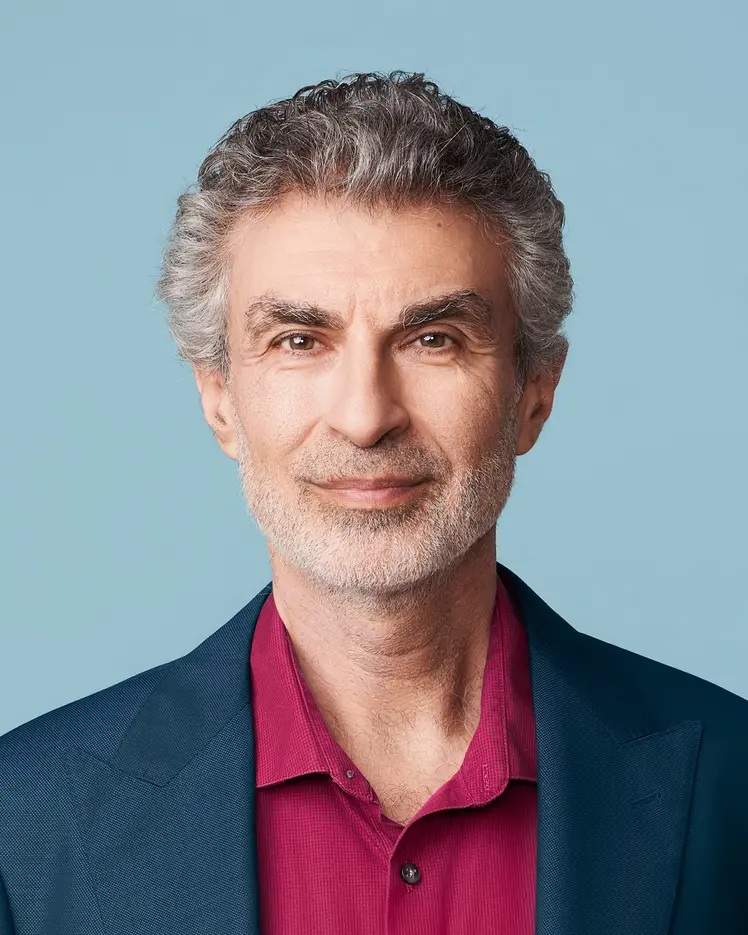

日経新聞[直言×超知能]

「AI脅威論はクレージー」

登場したのはヤン・ルカン氏、

64歳のフランス人。

メタ社チーフAIサイエンティスト。

1987~88年、カナダのトロント大学で、

ジェフリー・ヒントン教授の研究室に在籍。

米国ベル研究所やNECの研究所を経て、

2003年にニューヨーク大学教授。

2013年に旧フェイスブックに入社。

コンピューター科学における最高の栄誉、

「チューリング賞」を共同受賞。

ヒントン教授、

ヨシュア・ベンジオ(モントリオール大学教授)、

そしてヤン・ルカン。

3人は「AIのゴッドファザー」と呼ばれる。

その後の2024年、ヒントン名誉教授は、

ノーベル物理学賞を受賞。

しかしAIの脅威を巡って見解は分かれる。

ヒントン教授とベンジオ教授は脅威論者、

ルカンはそれを否定している。

ルカン。

「ジェフ(ヒントン名誉教授)とは、

この2~3年で見解が分かれた」

「ジェフは膨大なデータをAIに学習させる

大規模言語モデルに基づく知能の進化を

過大評価している」

「自我を持つ人間のように

物事を主観的に認識できると考えている。

私は全く信じていない」

「大規模言語モデルに

大量のデータを学ばせ続ければ、

人間並みの知能に達するという考えは

間違っている」

かつての同志、恩師に対して、

直截的な批判を述べる。

「大規模言語モデルは既存のデータをもとに

正解の確率が高い回答を導き出すものだ。

あらかじめ学んだ状況にしか対処できず、

人間のように未知の課題に対して

解決策を考え出すことはできない」

「これから3~5年ほどで

大規模言語モデルに代わる、

基盤技術の方向性が見えてくるだろう」

「すべてが順調であれば、

それから6~7年後に、

人間並みの知能にたどり着く可能性はある」

ルカンもAIの進化は否定しない。

「ただ、その道のりは

想定以上に複雑かもしれない」

「AI研究の歴史を見れば、

期待と失望を繰り返してきた。

つまり長い時間がかかるということだ」

「人間や動物のように

大量のデータを読み込まなくても

素早く効率的に

知能を育てられる仕組みが望ましい」

「現行モデルの延長線上で

人間並みの知能を開発しようとすると、

いずれ行き詰まる」

「乳幼児は五感を組み合わせて世界を観察し、

物理現象などの基本的な原理を自ら学ぶ」

「AIに大量の動画を見せて

物理空間について理解させようとしても

うまくいかない」

「人間並みのAIの実現には、

従来とは異なる基盤技術が求められる」

「若い研究者はリスクをとって

新手法を探す研究をするべきだ」

ここまでは生成AIの研究の、

方針の違いを強調する。

問題はAIが人間よりも賢くなったとして、

その暴走を防げるか。

ルカン。

「制御できる。

ボス(指示役)は人間だ」

「人間が最終的な目的を与え、

AIは目標達成に必要な行動を計画立てて

実行するという関係になる」

「AI搭載のロボットについても、

人に危害を及ぼさないように

事前に行動基準を定めれば

安全に利用できる」

「AIが人間のような知能を持ったとしても、

他者を支配したいという

能動的な欲望は持たないだろう」

「人間は生物学的な進化の過程で、

欲望を獲得した」

「人間の発明品であるAIが、

同じ欲望を持つ理由はない」

AIが他者を支配する欲望をもつか否か。

論点はここにある。

「AIが人間の頭脳に匹敵するには、

時間がかかる」

「前触れなくAIが急速に進化して、

人類を支配するといった、

脅威論はクレージーだ」

ルカンの根拠。

「AIの制御は工学的に可能だ。

人類が航空機を発明して

段階的に安全性を高めてきたように、

AI技術の安全な利用は人類に恩恵をもたらす」

一方、ヒントン名誉教授。

2023年5月のNHK国際ナビ。

「私の懸念は、AIが、

私たちが意図していない目標を

自分で勝手につくってしまうことです」

「人間は、たとえば、

ヨーロッパに行くとなったら、

その目的を達成するために、

まず空港に行くという小さな目標を達成します。

小さい目標の積み重ねで、

最終的な目標を達成していくんです」

「人間はこれを繰り返していますが、

AIが最終的な目標を達成するための

小さな目標をクリアしていくうちに、

意図しない方向に進んでしまうのではないか、

という懸念があるんです」

「いまは、とてつもなく不確実な時で、

われわれには何が起きるのかわかりません」

悲観的だ。

さらにベンジオ教授。

「今後2〜10年以内にAIは、

人間並みの能力を持つ可能性がある」

「世界的に規制が追いついておらず、

暴走リスクが高まっている」

そこでベンジオ教授は行動する。

「AIの監視役となるAI」の開発、

すなわち「正義のAI」である。

そのためのNPO「Law Zero(ローゼロ)」を、

つい最近の6月3日に設立した。

他のAIが異常な行動や人への危害を加える前に、

それを予測・制止する役割を持つAIを、

開発するのが目的。

NPOとした理由。

企業は資本市場の圧力によって、

「公共の利益が損なわれる可能性がある」ため。

ルカン。

「すべての技術は使い方次第だ。

現在のAI技術がサイバー攻撃に

どこまで利用できるかは不明だが、

少なくともサイバー防御には

役立つことがわかっている」

「人間社会には、

技術を悪用する人は存在し続ける」

「その被害をどう防ぐかという議論」が必要だ言う。

故スティーブン・ホーキング博士も生前、

AIを危険視していた。

哲学者のユヴァル・ノア・ハラリ。

加速するAI開発競争の真の危険性を警告する。

「 破滅的なのはAI技術そのものではなく、

人間同士の『信頼の崩壊』である」

一番若いルカンは楽観的だ。

ヒントン、ベンジア両教授は悲観的。

国際ニュースナビには、

3人が語り合う写真が掲載されている。

2024年5月21日、「欧州AI規制法」が成立した。

8月1日に発効し、2030年12月31日までに、

規制内容に応じて段階的に施行されていく。

これは正しい判断だと思う。

AIのゴッドファザー3人の見解。

私は「ファザーズ・デー」に頭を悩ました。

問題の根底には人間の欲望がある。

〈結城義晴〉